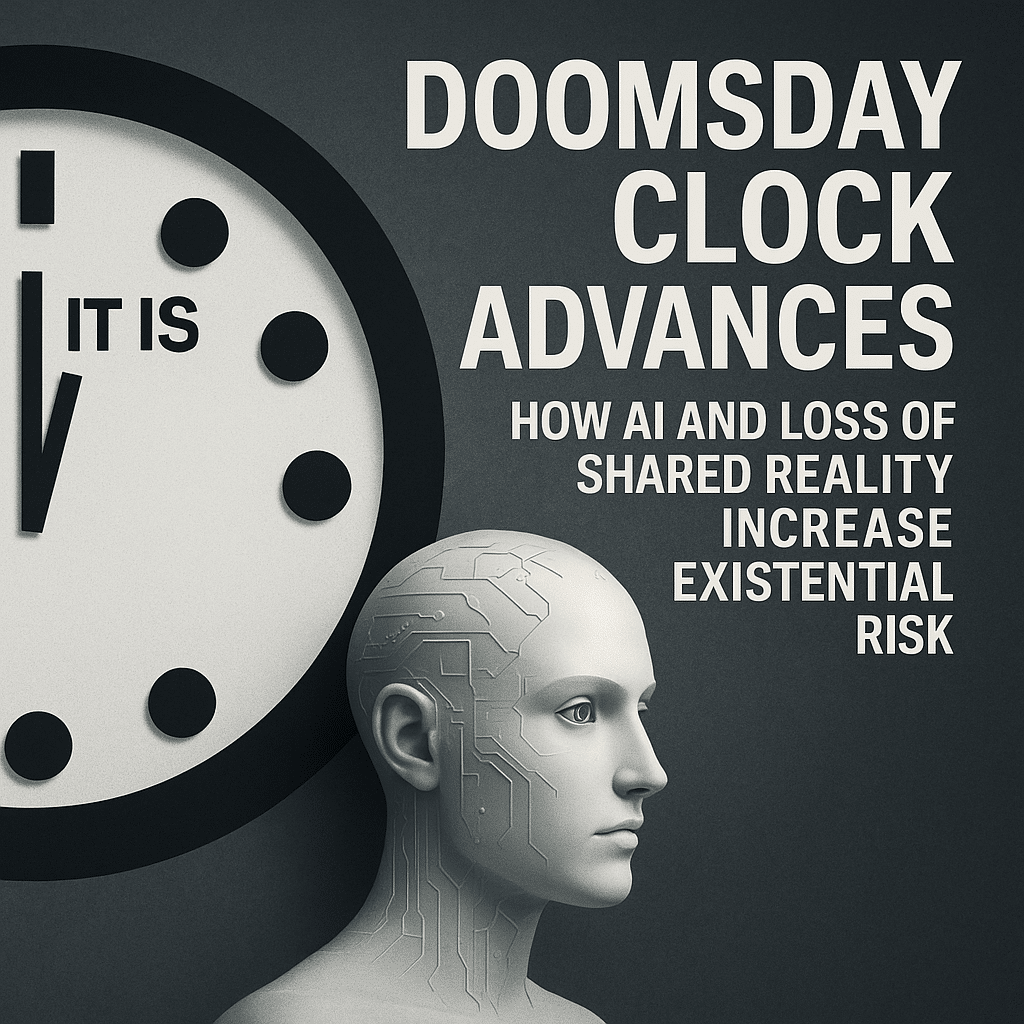

Introdução: o que mudou no Relógio do Juízo Final

Em janeiro de 2026, o Bulletin of the Atomic Scientists reposicionou seu simbólico Relógio do Juízo Final para 85 segundos para a meia-noite, um movimento de quatro segundos que, embora numérico pequeno, sinaliza uma avaliação agravada de riscos globais (REED, 2026). Entre as múltiplas explicações para esse ajuste, a inteligência artificial (IA) emergiu como um fator central: não pela narrativa simplista de robôs descontrolados, mas pelo impacto profundo que sistemas de IA têm sobre informação pública, estabilidade política, segurança cibernética e capacidades militares. Conforme reportado por Jon Reed na CNET, “It’s not because of runaway robots. It’s because we’ve lost a ‘shared reality’” (REED, 2026). Este artigo examina esse diagnóstico, detalha as vias de risco associadas à IA e propõe medidas de mitigação e governança.

Contexto histórico e significado do Doomsday Clock

O Relógio do Juízo Final, criado em 1947 pelo Bulletin of the Atomic Scientists, funciona como um termômetro simbólico dos riscos existenciais à humanidade, integrando ameaças nucleares, climáticas e tecnológicas. Alterações mesmo pequenas no ponteiro representam avaliações coletivas de fatores que afetam a probabilidade de catástrofes em escala civilizacional. A decisão de mover o relógio 4 segundos reflete, portanto, uma mudança agregada na percepção de ameaça global — uma percepção em que a IA assume papel proeminente (REED, 2026).

Como a inteligência artificial contribui para o aumento do risco

A inteligência artificial contribui para o aumento do risco existencial por múltiplas vias interconectadas. A seguir, descrevemos as principais.

Desinformação e erosão da realidade compartilhada

Sistemas de IA capazes de gerar conteúdos textuais, visuais e auditivos altamente convincentes ampliaram dramaticamente a capacidade de produção de desinformação em escala. A circulação massiva de deepfakes, textos gerados e narrativas fabricadas corrói a confiança nas instituições, no processo eleitoral e no jornalismo — elementos essenciais para a manutenção de uma “realidade compartilhada”. A perda dessa base comum de fatos facilita polarização, radicalização e tomada de decisões baseadas em premissas conflitantes, o que, em cenários extremos, pode precipitar crises políticas e conflitos internacionais (REED, 2026).

Automação de operações cibernéticas e militares

Algoritmos avançados otimizaram capacidades de ataque cibernético e de tomada de decisão operacional. A combinação de IA com sistemas autônomos aumenta a velocidade de procedimentos ofensivos, reduzindo janelas de resposta humana e elevando a probabilidade de escalonamentos acidentais. Em cenários de alta tensão entre estados, decisões automatizadas ou assistidas por IA podem produzir resultados não previstos por operadores humanos, agravando o risco de conflito convencional ou nuclear.

Dual-use e aceleração tecnológica em biosegurança

Embora menos diretamente referido por todos os analistas como a questão central, a IA acelera pesquisa e desenvolvimento em biociências, por exemplo, ao projetar sequências, simular proteínas ou otimizar processos laboratoriais. Essas capacidades podem reduzir barreiras técnicas, democratizar práticas complexas e, sem governança apropriada, aumentar o risco de incidentes ou uso mal-intencionado de agentes biológicos.

Risco sistêmico e interdependências globais

A IA não age isoladamente: ela interage com infraestrutura crítica (energia, finanças, telecomunicações), sistemas políticos e cadeias de abastecimento globais. Vulnerabilidades nesses domínios, exploráveis por agentes estatais ou não-estatais, são potencializadas por decisões algorítmicas opacas e dependências tecnológicas concentradas, elevando o risco de falhas sistêmicas de larga escala.

Perda da realidade compartilhada: definição e implicações

A noção de “realidade compartilhada” refere-se a um conjunto de fatos e interpretações básicos que permitem ação coletiva coordenada, legitimidade institucional e resolução pacífica de conflitos. Quando as populações e elites não conseguem concordar sobre elementos factuais fundamentais — por exemplo, resultados eleitorais, dados científicos ou eventos críticos — o tecido social que sustenta mecanismos de governança se rasga. Segundo Reed, a emergência de IA generativa intensificou esse problema, criando não apenas mais ruído informacional, mas simulacros que são difíceis de distinguir da realidade (REED, 2026).

Implicações práticas:

– Políticas públicas enfraquecidas: legislações e respostas emergenciais tornam-se contestadas e ineficazes.

– Perda de confiança nas instituições: erosão da autoridade moral e factual necessária para supervisão e coordenação.

– Mobilização social descontrolada: protestos, boicotes e respostas violentas podem emergir a partir de informações fabricadas ou distorcidas.

– Escalada entre estados: mensagens e incidentes aproveitados por atores para justificar represálias ou mobilizações.

Provas e indicadores observáveis

A avaliação de que a IA contribui para o avanço do relógio pode ser corroborada por indicadores observáveis:

– Aumento na detecção de deepfakes e conteúdo gerado por IA em processos eleitorais e campanhas de desinformação.

– Incidentes de ciberataques que empregaram automação e aprendizado de máquina para explorar vulnerabilidades em tempo real.

– Declarações de especialistas e agentes governamentais citando preocupações sobre a escalada de riscos tecnológicos que combinam IA e armas autônomas (REED, 2026).

– Relatórios acadêmicos e de organizações multilaterais que ligam difusão de IA a mudanças na resiliência de sistemas políticos.

Riscos de curto, médio e longo prazo

Curto prazo (0–2 anos)

– Amplificação de desinformação em ciclos eleitorais e crises geopolíticas.

– Ataques cibernéticos mais eficazes e automatizados.

– Incidentes de deepfake que desestabilizam mercados e políticas.

Médio prazo (2–7 anos)

– Integração ampliada de IA em sistemas de comando militar e infraestrutura crítica.

– Uso crescente de IA em biotecnologia com riscos de disseminação de habilidades.

– Erosão persistente da confiança pública, dificultando respostas coordenadas a crises.

Longo prazo (7+ anos)

– Potencial de sistemas autônomos com autonomia crescente em decisões letais.

– Mudanças estruturais na governança global decorrentes de fragmentação informacional.

– Riscos existenciais derivados de cenários de alinhamento adverso entre sistemas de IA avançados e interesses humanos.

Governança e mitigação: princípios estratégicos

Para enfrentar esses desafios, profissionais e decisores devem operar sob princípios claros:

Precaução e avaliação de risco

Adotar frameworks formais de avaliação de risco para sistemas de IA, integrando aspectos técnicos, sociais, políticos e éticos. Avaliações devem ser contínuas, multidisciplinares e visíveis ao público especializado.

Transparência e auditabilidade

Exigir registros, logs e mecanismos de auditoria independentes para modelos e sistemas críticos. A transparência técnica não elimina imediatamente riscos adversos, mas reduz assimetria de informação e melhora supervisão.

Regulação baseada em risco e interoperabilidade internacional

Desenvolver regulações proporcionais ao potencial de dano dos sistemas, com padrões técnicos compartilhados internacionalmente para interoperabilidade e mecanismos de verificação entre Estados.

Proteção da infraestrutura crítica

Segregar e proteger sistemas de controle com redundâncias e supervisão humana robusta; limitar a autonomia em domínios sensíveis (armas, redes elétricas, nucleares).

Educação e literacia digital

Investir em programas de literacia para profissionais, decisores e público para aumentar resiliência contra desinformação e deepfakes.

Cooperação público-privada

Empresas de tecnologia, governos e comunidade acadêmica devem formalizar acordos de cooperação para detecção precoce de abusos, resposta a incidentes e desenvolvimento de padrões de segurança.

Recomendações operacionais para organizações e profissionais

Para equipes de segurança cibernética e tomadores de decisão corporativos:

– Implementar detecção e mitigação de deepfakes e IA-generated content nas plataformas.

– Revisar políticas de resposta a incidentes incorporando cenários de manipulação informacional e ataques automatizados.

– Exigir testes adversariais e avaliações de robustez antes do lançamento de modelos sensíveis.

Para formuladores de políticas públicas:

– Estabelecer requisitos mínimos de documentação e avaliação de risco para modelos de IA com impacto público.

– Criar unidades interministeriais de monitoramento de riscos tecnológicos que integrem inteligência, saúde pública e infraestrutura crítica.

– Promover tratados e acordos de redução de risco tecnológico em fóruns multilaterais.

Para pesquisadores e academia:

– Priorizar pesquisas replicáveis sobre detecção de deepfakes, governança de IA e impacto sociopolítico.

– Desenvolver benchmarks para segurança e interpretabilidade de modelos de alto risco.

– Publicar avaliações de risco com linguagem acessível a formuladores de políticas.

Desafios e limites das respostas atuais

A governança eficaz da IA enfrenta obstáculos práticos: competição geopolítica, incentivos de mercado para velocidade de inovação, opacidade proprietária e dificuldades técnicas de detecção. Além disso, soluções tecnocêntricas isoladas não resolvem problemas de confiança social. É necessária uma abordagem sistêmica que combine regulação, design responsável, capacitação civil e mecanismos de responsabilização.

Cenários prospectivos: do pior ao melhor

Cenário pessimista

Fragmentação informacional leva a crises políticas simultâneas em potências nucleares, com respostas erráticas e escalonamento militar. Sistemas autônomos aceleram incidentes cibernéticos, contribuindo para falhas em infraestrutura crítica e possível conflito de alta intensidade.

Cenário intermediário

Adoção parcial de normas e melhores práticas reduz alguns riscos, mas a competição e lacunas regulatórias mantêm a probabilidade de incidentes significativos. O relógio oscila, exigindo vigilância contínua.

Cenário otimista

Cooperação internacional e regulação efetiva, aliadas a avanços técnicos em detecção e robustez, reconstroem parcialmente a realidade compartilhada e conseguem limitar usos maliciosos de IA. O risco existencial diminui mediante soluções combinadas de política, tecnologia e educação.

Conclusão: desafios práticos para preservar a estabilidade global

O movimento do Relógio do Juízo Final demonstra que a combinação de inteligência artificial com erosão da realidade compartilhada constitui um vetor real e crescente de risco existencial. Enfrentar essa ameaça exige um esforço coordenado entre governos, indústria, academia e sociedade civil. Estratégias técnicas (detecção, auditabilidade), institucionais (regulação, cooperação internacional) e sociais (literacia, transparência) são complementares e indispensáveis. Como aponta Reed, não estamos diante de “robôs desbocados”, mas diante de um ambiente informacional e tecnológico que, sem governança, mina a base de ação coletiva necessária para evitar catástrofes (REED, 2026).

Citação direta

“It’s not because of runaway robots. It’s because we’ve lost a ‘shared reality.'” (REED, 2026).

Referências no texto (ABNT)

No corpo do texto foram utilizadas citações e referências à reportagem de Jon Reed, conforme indicado: (REED, 2026).

Referência bibliográfica (ABNT)

REED, Jon. The Doomsday Clock Jumps Closer to Midnight. AI Is a Big Reason Why. CNET, 27 jan. 2026. Disponível em: https://www.cnet.com/tech/services-and-software/the-doomsday-clock-jumps-closer-to-midnight-ai-is-a-big-reason-why/. Acesso em: 27 jan. 2026.

Fonte: CNET. Reportagem de Jon Reed. The Doomsday Clock Jumps Closer to Midnight. AI Is a Big Reason Why. 2026-01-27T22:44:26Z. Disponível em: https://www.cnet.com/tech/services-and-software/the-doomsday-clock-jumps-closer-to-midnight-ai-is-a-big-reason-why/. Acesso em: 2026-01-27T22:44:26Z.